当前,仿人机器人在与人类进行情感人机交互时,面临无法生成复杂且真实面部表情的难题。由于现有技术限制,机器人无法像人类一样通过细腻的面部表情表达情感,这在一定程度上影响了用户的参与度和交互体验。因此,提升机器人生成自然表情的能力对于增强情感人机交互的质量具有重要意义。

学术界解决机器人情感表达问题的研究思路之一是利用预定义规则和硬件设计来生成机器人表情。生成的面部表情基于固定的规则和有限的表情类别,预定义的表情风格和种类有限,无法生成丰富且细腻的面部表情。此外,目前的预定义规则技术大多依赖于手动编码,缺乏灵活性,难以适应不同情境下的情感表达需求。例如,固定的表情编码无法捕捉到面部肌肉的微小运动,导致生成的表情不够自然,影响用户对机器人的情感理解和互动体验。

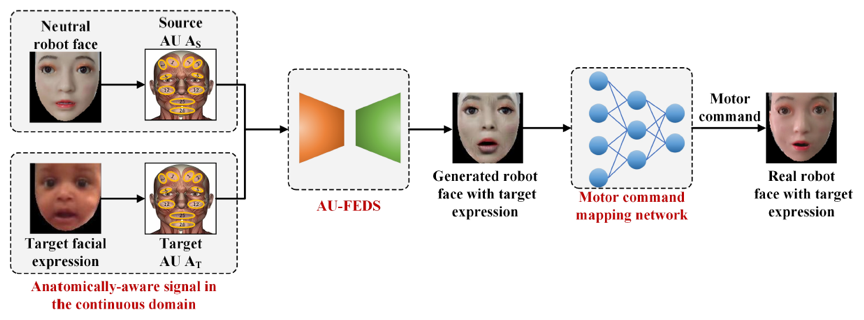

我校刘小峰教授团队联合英国曼彻斯特大学、英国莱斯特大学、常州大学科研人员基于现有技术在表情生成过程中捕捉面部肌肉细节的缺陷,设计了一种基于面部动作单元(Action Units, AUs)的表情解耦生成方法,探索了该方法在生成自然且细腻面部表情方面的效果,并进一步开发了一个具备多自由度面部运动的情感机器人(图1),以实际验证该方法在情感人机交互中的应用价值。这一研究旨在通过创新的方法,使机器人能够生成丰富且自然的面部表情,从而改善用户体验,并推动情感人机交互的发展。

图1:系统框架:连续域中的解剖级AU分布标签被检测为源AU AS和目标AU AT,将AS、AT和中性机器人面孔输入到AU-FEDS中,以生成具有目标表情的机器人面孔,随后将其输入到运动指令映射网络,以获得机器人的面部运动控制指令

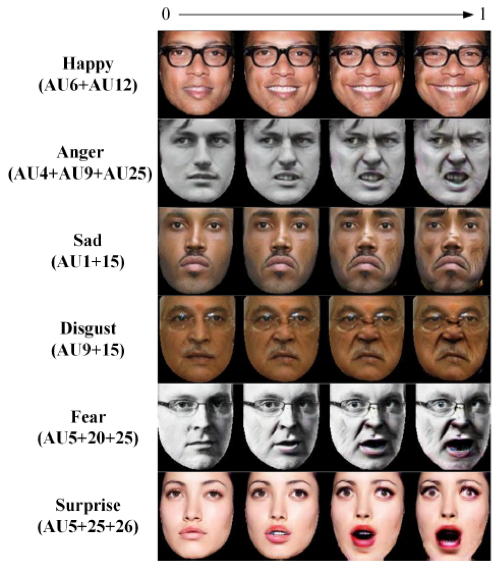

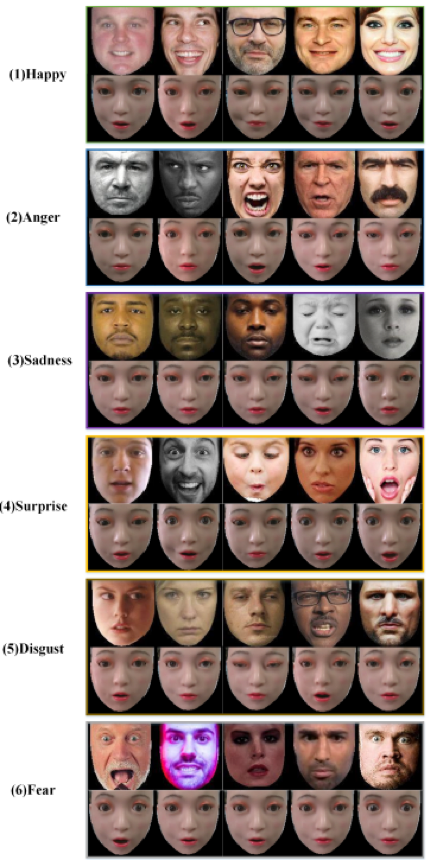

科研团队还开展了一系列实验,探索不同面部动作单元(AUs)在生成细腻面部表情中的具体作用和效果。首先,团队研究人员通过控制不同的AUs组合,生成六种典型情感表情,包括开心、愤怒、悲伤、惊讶、恐惧和厌恶(图2),实验探索编辑多个AUs生成离散面部表情的有效性。实验结果显示,该方法能够生成丰富且自然的表情,并能够准确反映复杂的面部肌肉运动。这表明,通过精细控制AUs,机器人能够呈现出细腻且多样化的情感表达。

图2:通过编辑多个AU生成的离散面部表情结果

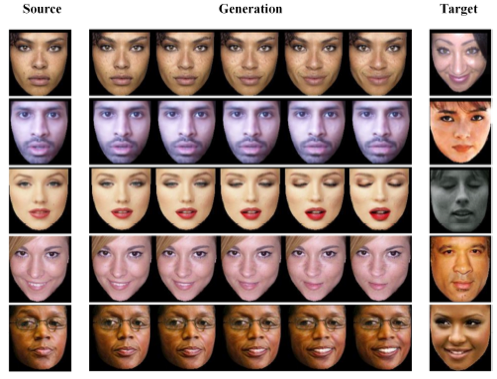

其次,团队研究人员选择了源表情和目标表情,并通过调整AUs的强度来生成中间的连续表情(图3),实验评估了连续面部表情生成的效果。结果显示,系统能够平滑地过渡表情,生成自然且连续的表情变化。这验证了所提出方法在生成连续表情方面的有效性,使机器人能够具有在不同情感状态之间过渡的能力。

图3:连续面部表情生成的结果

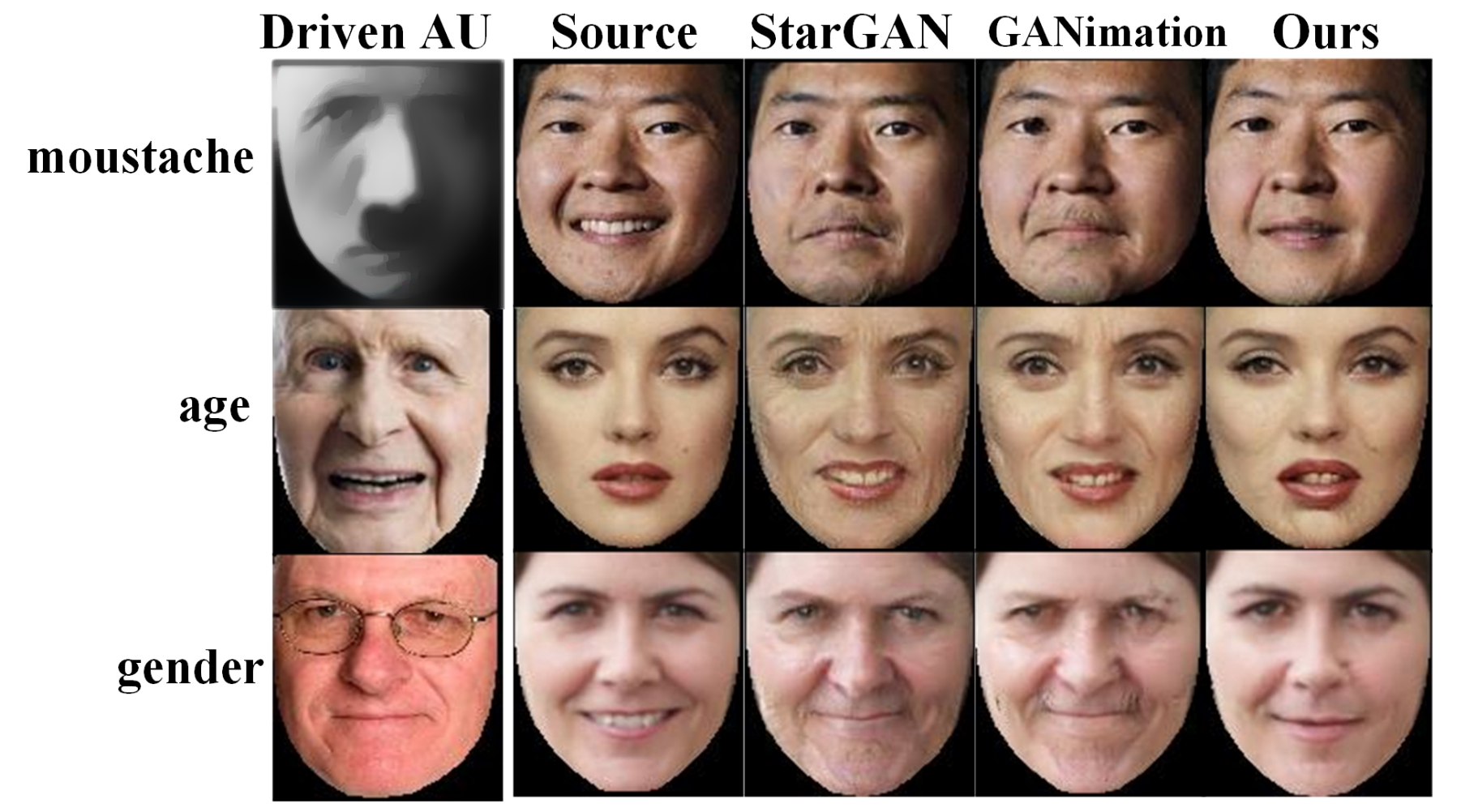

此外,为了评估不同方法在应对身份信息干扰时的表现情况,团队测试了AU-FEDS、StarGAN和GANimation三种方法,让它们处理带有胡须、皱纹等身份干扰信息的样本。结果表明AU-FEDS方法生成的图像比其他两种方法出现的伪影更少,并能更好地保持原始身份信息。这证明了AU-FEDS在处理带有身份信息干扰方面的优越性能。

图4:在带有身份干扰下使用不同方法生成面部表情结果图

最后,团队还进行了机器人在AUs标签驱动下生成各种表情的实验(图5)。通过设置不同的AUs标签,机器人成功生成了多种自然的表情,包括开心、愤怒、悲伤、惊讶、恐惧和厌恶。实验结果表明,在AUs驱动下,机器人能够生成细腻且自然的表情,从而显著提升情感人机交互的效果。这一发现表明,该技术在增强机器人与人类互动的自然性和有效性方面具有重要潜力。

图5:机器人在AU标签驱动下生成各种表情的结果图

本研究由我校人工智能与自动化学院刘小峰教授和常州大学倪蓉蓉讲师、杨彪教授、英国莱斯特大学宋思阳助理教授、英国曼彻斯特大学Angelo Cangelosi教授共同完成,研究成果在机器人领域国际顶级期刊《IEEE Transactions on Robotics》上发表了题为“Unlocking Human-Like Facial Expressions in Humanoid Robots: A Novel Approach for Action Unit Driven Facial Expression Disentangled Synthesis”的研究论文(https://ieeexplore.ieee.org/document/10582526)。该研究得到了国家自然科学基金面上项目(No.62276090)、国家重点研发计划项目(2018AAA0100800)以及江苏省重点研发计划项目(No.BK20192004)的资助。

《IEEE Transactions on Robotics》为机器人学领域公认的国际顶级期刊之一,要求论文在理论及工程实践上均能为机器人学发展作出重要贡献,其每年全球发文量约80-100篇,代表了机器人领域先进的重大进展,定位与规划方面的里程碑著作多数发表在该期刊上。